- Akciófigyelő: Humble Games Bundle - Nightdive FPS Remasters

- Call of Duty: Modern Warfare III - Új szezon, újabb ingyenes hétvége jön

- Hunt: Showdown - Jön az engine csere, befutnak az újgenerációs verziók

- Steamre tart a Crime Boss: Rockay City

- The Witcher - Befutott a TV sorozat folytatásának első rövid kedvcsinálója

Új hozzászólás Aktív témák

-

BeZol

őstag

válasz

Alvin_ti4200

#476

üzenetére

Alvin_ti4200

#476

üzenetére

1. AMD RX 6900 XT bemutatója 2020. okt. 28-as videóból: [link]

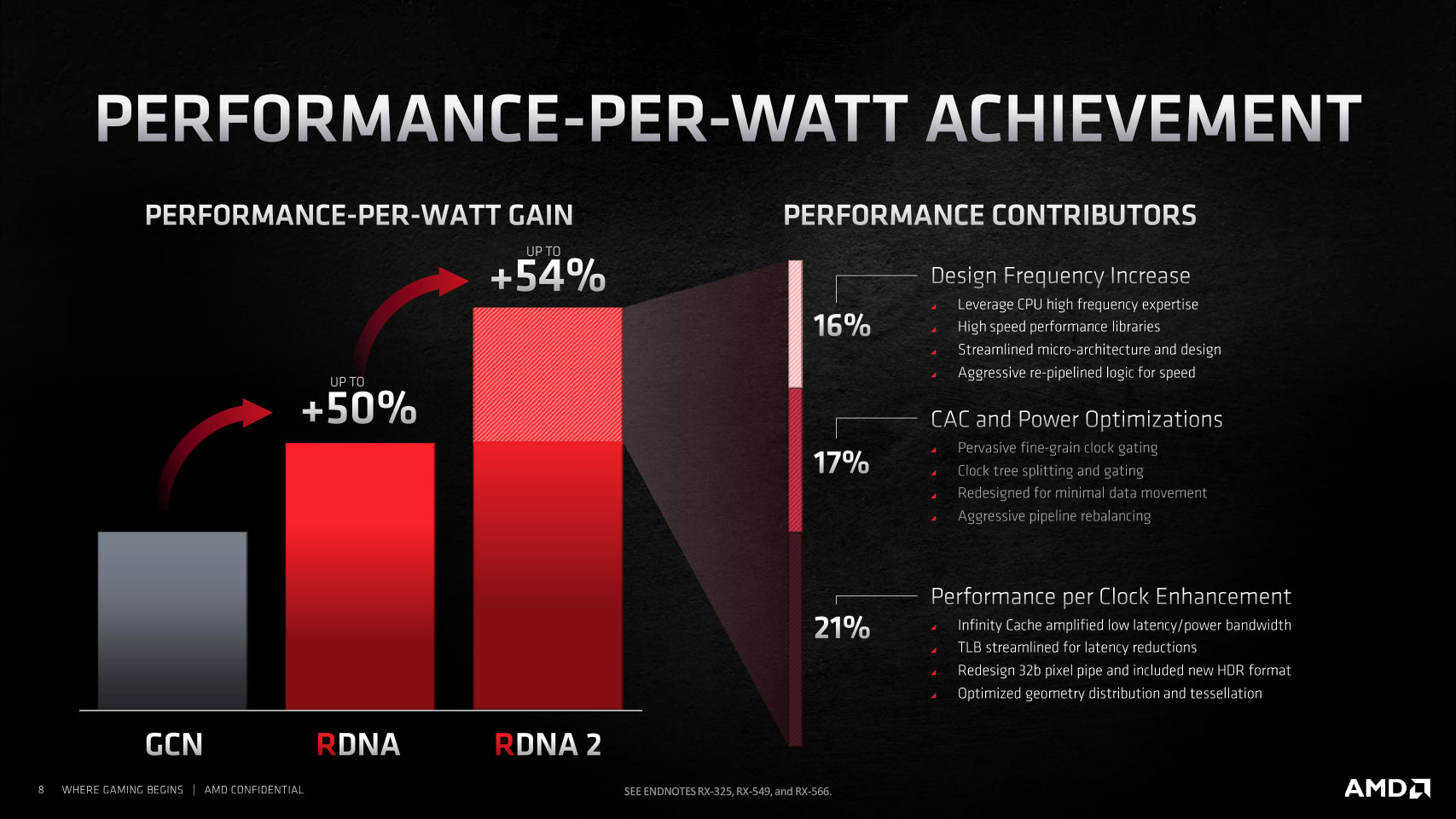

Itt +65% perf/W-ot claimeltek.2. 2020. dec. 8-adikai review-k hivatalos anyaga már csak +54%,

így lett összességében a korábi RX 5700 XT-hez képest 4K alatt 2xer erősebb

(5700 XT 40cu, 6900 XT 80 cu, szóval gyakorlatilag is 2x annyi anyag van benne):

A fogyasztás 36,5%-kal növekedett, de szépen skáláznak 326W-ig, szóval ez csak gyári korlátozás miatt ennyi. (5700 XT ami ref kártya járt anno nálam, azt kb. 160-180W-ra feszelve tudtam csak használni 10% teljesítménybuktával, egyébként throttlingolt. Ezek tehát gyárilag túl voltak hergelve)

A legutóbbi pletykák alapján most nem 2xer annyi cucc lesz a next gen-jükben, hanem 2,5xer annyi cucc, mellette pedig majdnem 4GHz-re OC-zhatóak (mostaniak stabilan 2550+MHz-re, jobbak 2800MHz környékére, extrém OC-zva 3GHz is megvan), kérdés hova lövik be a TDP-keretet. Tehát lesarkítva legyen 3,5GHz és így +40% órajel, ami mellé 2,5xer annyi cucc. A kettő eredője 3,5x teljesítmény lenne.

RTX 4090-esnél viszont már tudni, hogy a gyakorlatban 2,8GHz körüli boost-on járnak 450W-ból (sima FE kártya).

Az RTX 3090 Ti (FE-kártya) 1979MHz-et tartja 450W-ból. [link]

Ez +41,4% gpu-órajelben, tehát azonos 10.752 db cuda core-al ennyivel lenne erősebb a 4090.

Az RTX 4090-esben viszont 16.384 db cuda core van, ami további +52,4%-ra adna lehetőséget.

A kettő eredője lenne 2,15x teljesítmény, ami esélyesen 800W körülből lenne meg![;]](//cdn.rios.hu/dl/s/v1.gif)

Szóval sztem megöli a bulit a TDP-keret, ezért is várom nagyon a 600W-os OC-példányokat.Az AMD-nél viszont 3,5x-re jött ki az elméleti matek.

Itt ugyanakkor bemutatnám az RX 6700 XT vs RX 6900 XT esetét:

"Cucc" ügyileg 2560 vs 5120 --> 2x a 6900 XT-nek

Órajelben 1,15x a 6700 XT-nek.

Az eredőjük alapján elméletben +74% a 6900 XT-nek.

És ebből lesz 4k-ban 1,53x [link] a 6900 XT-nek. (1440p-ben 1,39x)

A fogyasztás 221W vs 299W (+41,7%).

Tehát az elméleti matek 2/3-a ha teljesül szérián belül!

Szimplán ez alapján a 3,5x elméleti gyorsulás 2/3-át véve 2,67x-re csorbulunk.

A fogyasztási arányokat nézve olyan kb. +65% áram kellene (2,5xer annyi cucchoz) ehhez a 2,67x-hez, tehát 299W helyett 493W-ról beszélnénk.

A 7nm kontra 5nm előnye az "azonos helyre több fér el" mellett a magasabb órajel és/vagy azonos teljesítmény mellett kisebb fogyasztás, és mivel az órajelet kvázi tudjuk (3,5GHz+), ezért itt kb. ez a gyártási előny nagy része. Itt is a TDP-kereten múlik majd a dolog, de így a fentiekből következtetve ha AMD is elmenne 450W+-ra, akkor egy 2,5x összehozhatónak tűnik, vagy egy 2x 350-400W között.Másik megközelítés +50% perf/W alapján (ami azonos RDNA vs RDNA2-re nézve is, nem csak RDNA 2 vs RDNA 3-ra nézve).

6900 XT tudást 299W helyett 200W-ból kéne tudniuk.

Egy másik review alapján az 5700 XT 210W (és nem 221W), a 6700 XT 221W, és itt 33%-kal erősebb a 6700 XT, szóval sehogy sem jön ki a marketingelt +54% perf/W, hanem ismét csak a 2/3-a!

Ha egy ilyen általános 33%-kal számolunk, akkor 299W-ból 6900 XT *1,33x teljesítményt kéne kapnunk. Innentől marad a TDP-keret kérdése.

6700 XT vs 6900 XT-z néve kb. amennyivel nőtt a fogyi, annyival nőtt a teljesítmény (úgy, hogy közben 2x cucc volt a 6900 XT-ben, na most RDNA 3 esetén 2,5x cucc lesz).

Tehát ha 299W-ről felküldik a next gen AMD-t 450W-ra, akkor 1,33x * 1,5x --> 1,995x teljesítményt kapunk így, kerekítsük 2x teljesítményre

5700 XT vs 6600 XT NVIDIA módra: (ugyanolyan erős a next genjük)

RTX 2080 Ti - 4352 cuda core, 1824MHz average gpu clock, 273W

RTX 3070 - 5888 cuda core, 1882MHz average gpu clock, 220W

--> +35% cuda core, +3% gpu-órajel, 80%-nyi fogyasztással --> 1,35*1,03*0,8 = +11,24% teljesítményt kellene hoznia a 3070-nek 220W-ból, ehelyett egyforma erősek.

(RTX 3090 Ti vs RTX 4090: 1,52*1,41*1 = 2,14x, ezt leosztva 1,1124-el 1,93x-et kapunk)

November végére kiderül mely forgatókönyvek futnak be.3. 2020. okt. 28 és dec. 8 között bő 1 hónap eltelt ÉS alig volt készletük Nvidia-hoz képest.

4. Legutóbbi pletyka alapján a 2022. nov. 3. csak bemutatás mint anno az okt. 28, kapható nov. 20 utántól lehet, DE a lentiekből

nekem az jön le, hogy lesz pár ref kártya, a custom verziókra meg még lehet várni +1 hónapot.

A mostani ref kártyák OC-potenciálja 0% közeli (inkább csak alulfeszelve OC-zható, amit finomhangolásnak neveznék csak), de out of the box teszik a dolgukat mint Nvidia FE kártyái.5. 6800/6800XT/6900XT (ugyanaz a chip) eléggé rendesen coil whine-ol az összes saját tapasztalatok alapján (1db ref 6800, 1db ref 6800 xt, 1db sapphire nitro+ 6800 xt, 1db gigabyte aourus 6800 xt, 2db ref 6900 xt, 2db red devil 6900 xt, 1db red devil ultimate 6900 xt, 3db asrock oc formula 6900 xt). Ugyanez Nvidia oldalról csak Asus TUF és ROG Strix karikkal jött elő nálam (1db TUF 3060 Ti, 4db Strix 3080/3080Ti + 1db White Strix 3080), de 3 kivétel is volt ASUS-on belül (1db TUF 3070 és 2db TUF 3070 Ti), az AMD-nél viszont az összes nyomta a coil whine-t gyártótól függetlenül.

6. Szintén személyes tapasztalat, hogy igazából hiába nyerőbb az AMD játékra ár/teljesítmény alapján, szinte minden ismerős megbánta h AMD-t vett.

A fenti cw is zavaró, de ha épp nem brutál hangos, akkor simán élhető. (rendszerfüggő)

A fő-fő probléma az AMD-kártyákkal a szoftveres helyzet:

- Multi-monitor setupokkal szokott komplikáció lenni már akár sima youtube-ozáskor is.

- Jön egy új WHQL driver, és simán lehet h xy játék onnantől crashelget vagy akadozik..., de egy újabb játék miatt viszont tényleg kellene ez a driver, a régi játék miatt meg a korábbira kéne visszamenni...

- Random driver crashek akár simán netezés közben is.+1 hardveres:

- GPU-hotspot problémás darabok amik gyárilag 100 fok hot-spotot produkálnak, így custom kártya esetén OC-zhatóság kuka, DE 110 fokig AMD-szerint nem probléma és nincs gariztatás. (cserébe RTX 3xxx-eknél meg GDDR6X hőfok-problémák vannak)Én azt mondom a fentiekre, h még ezekkel is együtt lehet élni, DE számomra az igazán nyomós ok arra, h miért nem érdemes AMD-t venni az az, hogy a játékfejlesztők részéről sincsen elég szoftveres támogatás.

Van, akiknek a COD: Warzone a mindene, és egyik patch utántól micro-stutterezett nekik az egész.

Van, aki csak PUBG-zne, és az 1% low fps-ek alapján is be-beakad a játék, ami irritáló ha amúgy bőven megvan az fps.

Most meg épp Apex Legends-el is vannak problémák ahogy olvasom.

Ezek kérem szépen nagyobb AAA játékok amikkel rengetegen játszanak napi szinten, és sokszor hónapokig nincsen megoldás 1-1 problémára!!! Mi lehet a többi játéknál?

--->

Ezek után az AMD csupán 1 okból várós: árverseny miatt.

Elvileg jóval olcsóbb gyártani az AMD-kártyákat (mert kisebbek a chipek és nincs drága GDDR6X memória), erre most a chiplet design rádob majd még1 lapáttal (olcsóság irányába), ugyanakkor a chiplet design miatt én további szoftveres anomáliákat várnék...

(ráadás: az első ryzen procik sem voltak jók játékra )

)Egy szó mint száz, akinek fontos a rendszere stabilitása és nem akar minden héten vmi miatt kiakadni, az jobb ha Intel konfigot dob össze Nvidia videókártyával még akkor is, ha éppen ár/teljesítményben egy AMD konfig adná ki. (+1 a ray-tracing miatt az Nvidia-ra)

Megszűnnek a ráncok, kisimul az arc és rájön az ember, hogy jé, lehet ezt így is?

Lehet!

Új hozzászólás Aktív témák

- MSI RTX 4060 Ti Ventus 2X Black 16G OC felbontott, 3 év gar, tökéletes VGA, névre,cégre Áfá-s számla

- Palit GameRock RTX 4070 Ti BONTATLAN

- Új, 3 év garancia Inno3D GEFORCE RTX 4080 SUPER X3 NVIDIA 16 GB GDDR6X

- BESZÁMÍTÁS! ÚJ AORUS MASTER / ROG STRIX WHITE RTX 4090 24GB videokártyák számlával 3 év garanciával

- Gigabyte Aorus Master 4090 + EKWB 4090 Nickel Acetal blokk

Állásajánlatok

Cég: Ozeki Kft.

Város: Debrecen

Cég: Promenade Publishing House Kft.

Város: Budapest

![;]](http://cdn.rios.hu/dl/s/v1.gif)

)

)